Pues sí, en la Cámara de Diputados ya no hace falta leer las iniciativas para votarlas. Basta con tener ChatGPT y listo. Así lo explicó la diputada de Morena, Olga Leticia Chávez Rojas, quien sin pena soltó que para “leer” documentos de más de 200 páginas, ella mejor le pide a la IA que se los resuma. ¿Para qué molestarse? No es como si su chamba implicara leer eda’.

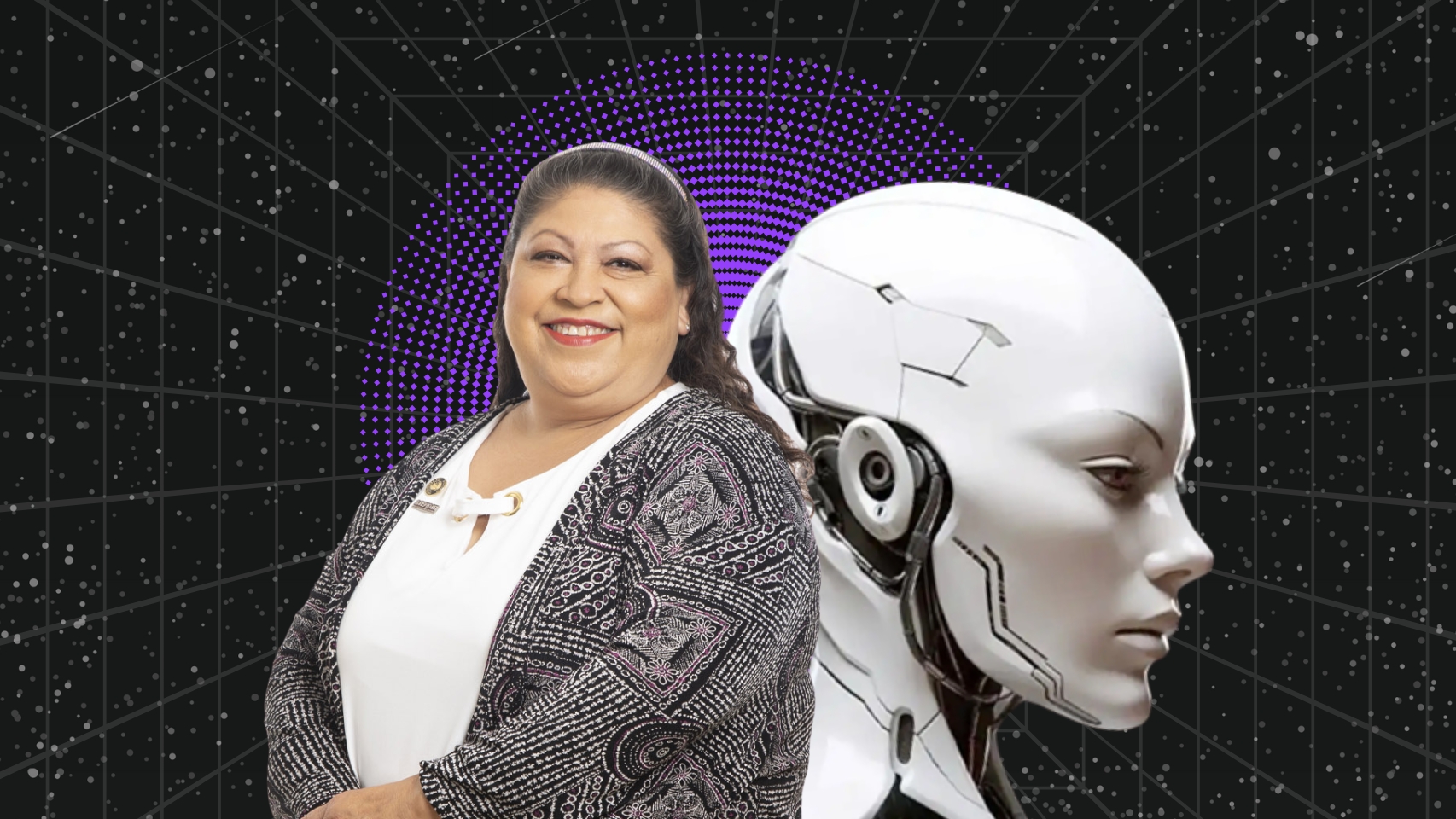

Diputada de Morena hace resumen con ChatGPT

Todo salió a la luz luego de que en menos de 24 horas los y las diputadas se echaron el “análisis” y aprobación de una iniciativa de 205 páginas relacionada con seguridad y vigilancia en México. Porque cuando se trata de cosas como espiar ciudadanos o ampliar el poder del Estado, al parecer no hay tiempo que perder.

Durante la discusión, y visiblemente molesta, la diputada Chávez Rojas tomó el micrófono para defenderse de quienes la acusaban (a ella y su bancada) de no leer las propuestas:

“Ya basta de que nos estén diciendo que no leímos las iniciativas. 205 páginas tiene el dictamen (…) estos personajes del PRI no se han actualizado: no mencionan los avances que ha tenido la ciencia”.

La ciencia, en este caso, es pedirle un resumen a ChatGPT. Y como si eso no fuera suficiente, lo presumió con orgullo: “Si nosotros metemos esta iniciativa en una Inteligencia Artificial nos la puede dar en la mitad del tiempo, en el cuarto del tiempo. Te lo reduce hasta en 15 minutos”.

Y cerró con broche de oro, dejando claro su desprecio por el método tradicional de leer: “¡Actualícense, ignorantes!”. Alguien dígale que le pregunte al mismo ChatGPT por qué lo que hace está mal, quizá así sí lo lea.

¿Pero por qué está mal que usen IA para leer iniciativas?

Aunque usar IA para resumir puede parecer práctico, no es lo ideal, sobre todo para decisiones legislativas. Simplemente hay que tener en cuenta que no todo lo que dice la IA es cierto: ChatGPT puede resumir, sí… pero también puede inventar cosas, malinterpretar datos o perder puntos clave.

Además, no capta matices legales ni políticos. Una iniciativa de ley no es un post de Facebook o un texto cualquiera. Tiene tecnicismos, contextos históricos, implicaciones jurídicas… que la IA puede pasar por alto. ¿Quién se hace responsable si algo sale mal? Si la diputada vota basándose en lo que le dijo una IA, ¿a quién le echamos la culpa? Porque la responsabilidad sigue siendo humana.

IA: herramienta, no reemplazo

No es lo mismo si tú como ciudadano le pidieras a ChatGPT que te explicara una ley, porque aunque pudiera dar datos erróneos, no estás tomando decisiones que afecten a millones de personas.

En cambio, cuando un legislador usa ChatGPT para resumir una iniciativa y con base en eso vota, está delegando su responsabilidad en una herramienta que no tiene criterio, ni contexto político, ni consecuencias. La diferencia está en el peso de la decisión: tú buscas entender, ellos están decidiendo el rumbo del país.

Sí, la inteligencia artificial puede ser una aliada para entender temas complejos o filtrar información, pero jamás debería sustituir el análisis crítico y el juicio humano. Mucho menos en el Congreso. Recuerda, una IA es solo una herramienta para optimizar procesos no para que te sustituya y haga todo tu trabajo.

Así que, mientras algunos diputados del oficialismo prefieren confiar en resúmenes automáticos, ojalá también se actualicen en algo más importante: la responsabilidad que implica legislar para todo un país. Pero parece que la de leer y usar el pensamiento crítico no se la saben.

Deja un comentario